Destination cette semaine annoncé un nouveau modèle d'intelligence artificielle (IA) ouvert la source reliant plusieurs types de données, y compris le texte, l'audio, les données visuelles, la température et les lectures de mouvement. Le modèle n'est pour l'instant qu'un projet de recherche, sans applications pratiques ou grand public immédiates. Cependant, il pointe vers un avenir de systèmes intelligence artificielle générative capable de créer des expériences immersives et multisensoriel. Il s'appelle Meta ImageBind et on vous explique comment ça marche.

Meta présente ImageBind, un nouveau modèle d'IA multisensoriel open source. Voici comment cela fonctionne et ce qu'il peut faire

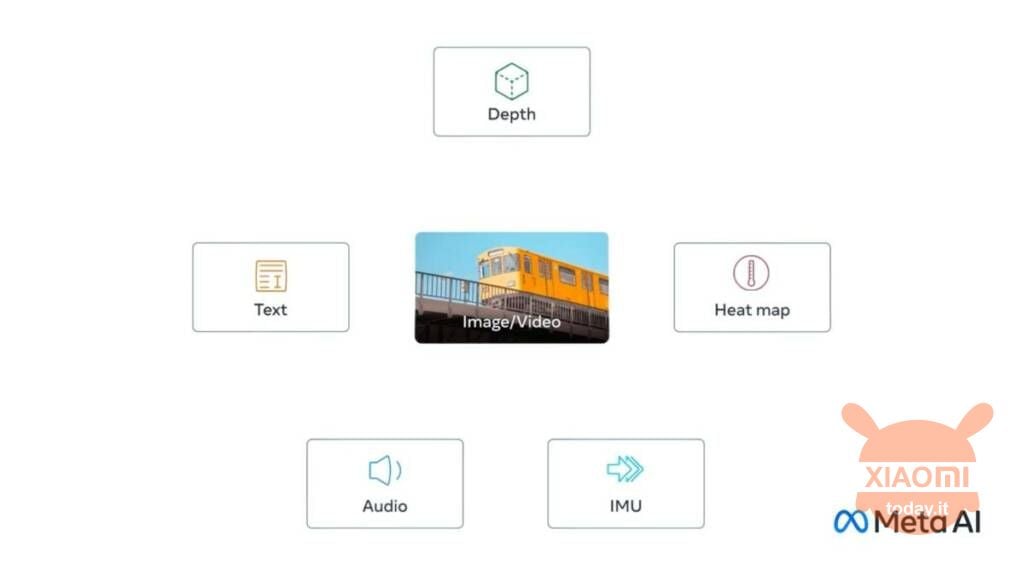

La nouveauté s'appelle Meta ImageBind et est la première à combiner six types de données dans un seul espace multidimensionnel. Les six types de données inclus dans le modèle sont :

- Visuels (sous forme d'images et de vidéos)

- Thermique (imagerie infrarouge)

- Textes

- Audio

- Informations détaillées

- Lectures de mouvement générées par une unité de mesure inertielle, ou IMU

Lire aussi: Meta présente SAM, l'IA qui identifie les éléments individuels dans les images

L'idée est que les futurs systèmes d'IA peuvent faire croiser ces données de la même manière que les systèmes actuels le font pour la saisie de texte. Imaginez, par exemple, un dispositif de réalité virtuelle futuriste qui génère non seulement des entrées audio et visuelles, mais aussi notre environnement et notre mouvement sur une scène physique. L'utilisateur peut demander à l'outil de imiter un long voyage en mer, et le mettrait non seulement sur un navire avec le rugissement des vagues en arrière-plan, mais aussi le pont qui se balance sous les pieds et la brise fraîche de l'air de l'océan. L'idée est que la plateforme combine différents formats de données pour générer le résultat.

Dans un article de blog, Meta note que d'autres flux d'entrée sensoriels pourraient être ajoutés aux futurs modèles, y compris "le toucher, la parole, l'odorat et les signaux cérébraux IRMf“. Cette nouvelle fonctionnalité n'est pas encore prête, la communauté n'est donc pas en mesure de la tester à ce stade précoce, même si elle est à un stade avancé de développement.