Récemment, Amazon lancé son chatbot IA Amazon Q, suscitant l'intérêt des entreprises mais aussi l'inquiétude des employés concernant de graves problèmes d'exactitude et de confidentialité. Q a été signalé pour avoir «hallucinations de non poco conte" et divulgué des données confidentielles, soulevant des questions sur la sécurité des informations de l'entreprise. Voici les détails divulgués par Plates-formes.

Alerte de sécurité pour Amazon Q : entre données confidentielles et réponses incorrectes

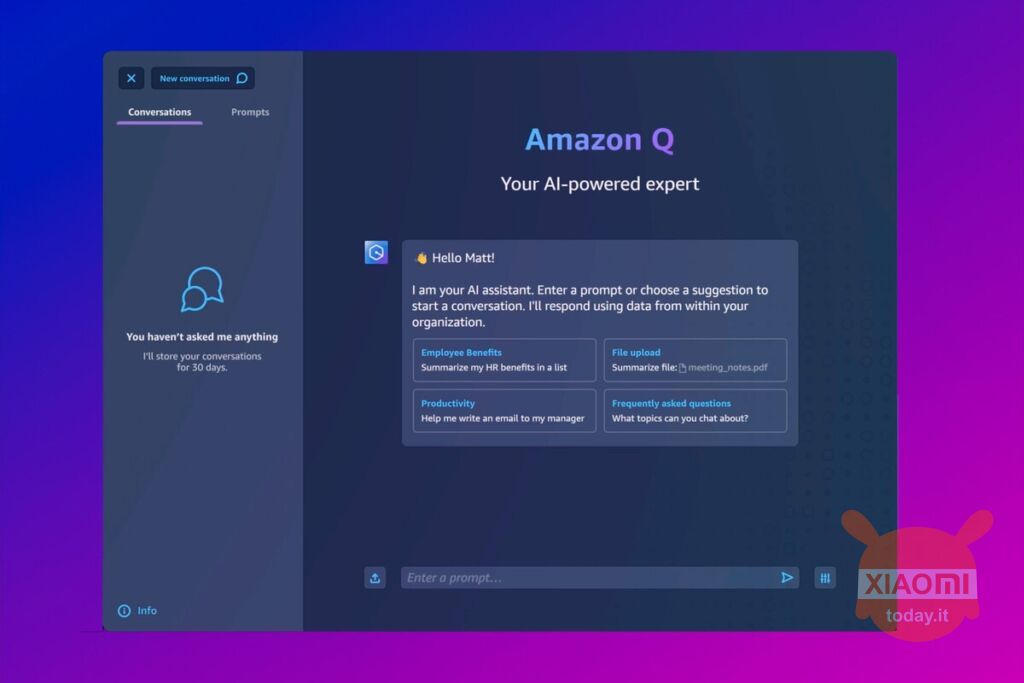

Amazon introduit son chatbot IA, appelé Q, il y a trois jours, mais tout ne semble pas se dérouler comme prévu. Certains employés ont tiré la sonnette d'alarme sur des questions d'exactitude et de confidentialité : Amazon Q aurait manifesté des « hallucinations » et révélé information confidentiel, comme l'emplacement des centres de données AWS, les programmes de remise internes et les fonctionnalités non encore publiées.

Cette information est issue de documents divulgués et obtenus par Plates-formes, mettant en évidence un Problème de sécurité de niveau 2, une situation grave qui nécessite une intervention urgente des ingénieurs.

Malgré cela, Amazon a minimisé l’importance de ces discussions internes. Un porte-parole a déclaré que le partage de feedback via les canaux internes est une pratique courante chez Amazon et qu'aucun problème de sécurité n'a été identifié à la suite de ces commentaires. L'entreprise a souligné l'importance des retours reçus et la volonté de continuer affiner Amazon Q lors de sa transition de la préversion à la disponibilité générale.

Amazon Q, actuellement disponible en avant-première gratuite, a été présenté comme un version du logiciel d'entreprise d'un chatbot, avec des fonctions initiales visant à répondre aux questions des développeurs sur AWS, à modifier les codes sources et à citer les sources. Amazon a mis l'accent sur la sécurité et la confidentialité de Q, en le comparant à des outils grand public comme ChatGPT.

Cependant, un document interne a révélé que Q peut « halluciner » et fournir des réponses nuisibles ou inappropriées, telles que informations de sécurité obsolètes ce qui pourrait mettre les comptes clients en danger. Ces risques sont typiques des grands modèles de langage, qui ont tous tendance à fournir des réponses incorrectes ou inappropriées, au moins à certaines occasions.

Via | Slashdot